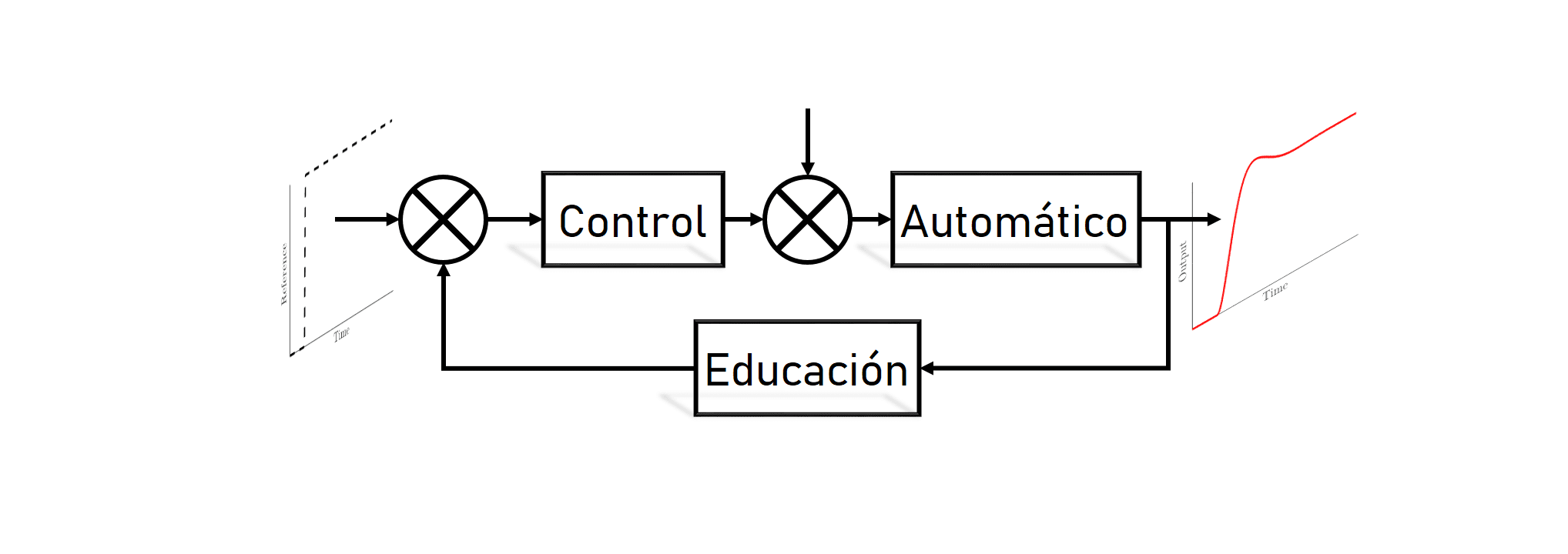

La página controlautomaticoeducacion.com nasce con la idea de difundir, enseñar y contribuir al área de control de procesos, programación, sistemas embarcados, sistemas de automatización y modelado de sistemas. Temas que hacen parte del currículo de varias ingenierías.

Aquí encontraras información que puede ser útil, y que podrás aplicar tanto en tu vida académica como en tu vida laboral.

Cursos

A continuación, te presento todos los cursos de la página. La mayoría de los temas tienen vídeos de explicación a través de YouTube junto con toda la información necesaria para entender el material disponible. Para acceder a la información basta solo dar CLICK sobre la imagen de cada Curso:

Sistemas Embebidos

Lenguajes de Programación

Sistemas Dinámicos

Teoría de Sistemas de Control

Instrumentación Industrial

¿En que Orden debo ir?

Si estás interesado en aprender sobre la teoría del control, mi recomendación es primero entender los sistemas, para posteriormente entrar a entender los controladores, por lo tanto el orden sería el siguiente:

- Análisis de Sistemas: Aprende a modelar y linealizar sistemas. A usar la transformada de Laplace.

- Sistemas Dinámicos Lineales: Aprende sobre las variables de estado y posteriormente comenzamos a entender el control por realimentación de estados.

- Control Realimentado: Aprende sobre conceptos de los sistemas de control: respuesta frecuencial, tipos de sistemas, controles PID, compensadores de tiempo muerto.

- Control de Procesos: Controles avanzados diferentes al clásico PID.

- Control MPC: Hace parte de los denominados controles avanzados dentro del concepto de controladores óptimos, muy utilizados en industrias petroquímicas y de petróleo y gás.

Como Navegar en la Pagina

Si tienes alguna duda de como navegar en la página web, a continuación, te muestro un video explicándote todas las funcionalidades de la página, para que puedas obtener el mejor provecho de toda la información aquí disponible:

Ingenieria de Control, Instrumentación y Automatización

La teoría de control es una rama de diversas ingenierías tales como la propia ingeniería de control, ingeniería electrónica, química, mecatrónica, eléctrica, entre otras. La teoría de control formula leyes matemáticas para describir el comportamiento dinámico de sistemas físicos conforme a ciertas especificaciones y restricciones del propio proceso y su estudio es la esencia para el desarrollo y automatización de procesos industriales. El control automático nos brinda las bases para realizar una automatización industrial donde se busca obtener el funcionamiento óptimo de cualquier sistema dinámico.

La instrumentación y control presentes en cualquier planta industrial nos permiten regular las diferentes variables presentes en el proceso con el fin de poder garantizar los diferentes objetivos económicos y de especificación, bien sea aplicando la teoría clásica como los reguladores PID (control PID), o aplicando sus parcelas fundamentales como el Control Proporcional (control P) o el control Integral, o la union de los dos Controlador PI. En esta misma rama se puede pensar en usar estrategias avanzadas como el control predictivo basado en modelo.

Todas estas estrategias pueden ser implementadas en sistemas embebidos tales como microcontroladores (PLCs, PIC, Arduino, Motorola, Raspberry, Atmel, etc) y también en computadores usando software con lenguajes especializados (MATLAB, Labview, Phyton, C, etc) siempre aplicando la teoría del control digital.

Puedes aprovechar y darle un vistazo al curso de MATLAB de la página y comenzar a aprender desde CERO este interesante Software.

Con el estudio y el avance en la teoría de Control, el hombre ha conseguido avances significativos en el campo de la ciencia convirtiéndose en parte fundamental de sistemas robóticos, sistemas de navegación espacial, procesos modernos de fabricación y en cualquier operación industrial que requiera el control de temperatura, presión, humedad, flujo, etc. Sin embargo, el control no se encuentra únicamente en la ciencia, sino que también lo podemos ver en nuestras vidas cotidianas, como por ejemplo el controlador interno de nuestros coches, el control de malla abierta de nuestras cafeteras, duchas, e infinidad de procesos domóticos que podemos comenzar a ver como una tendencia en diferentes hogares o centros comerciales de nuestra ciudad.

En este blog pretendo abordar de una manera muy sucinta y detallada diferentes temas del área de control enfocados principalmente a la ingeniería electrónica e ingeniería química, abordando tópicos como el análisis frecuencial, el análisis y modelado de sistemas, programación en Matlab y en microcontroladores, el estudio de controladores clásicos, modernos y avanzados, entre otros. Por lo tanto esta página tendrá un constante crecimiento, he irá de la mano junto con el canal en Youtube en la medida que consiga un poco de tiempo libre.

¿Que temas vas a encontrar en este sitio web?

Control Automatico Educación es un sitio web especializado en el control, automatización, análisis y instrumentación de procesos. Aqui obtendrás conocimientos de todo tipo de temas relacionados a ingeniería como la representación de sistemas de primer orden, sistemas de segundo orden, el análisis frecuencial usando el diagrama de bode, que es la función de transferencia control, la descomposición canonica en espacio de estados o formulas básicas como el teorema del valor inicial y final en Laplace y transformada Z.

También encontrarás implementaciones prácticas en dispositivos electrónicos para llevar la teoría al mundo real, como por ejemplo sabrás como hacer un PID, el cual es uno de los controladores industriales más usados en el mundo. Para lograr esto aprenderás programación de PIC en C desde cero. Y con el tiempo aprenderás a programar otro tipo de dispositivos como Arduino, Raspberry, etc. Manejaremos varios tipos de périfericos como el teclado matricial, la pantalla LCD, veremos los tipos de motores a pasos que existen, servomotores entre otros. No te pierdas nuestro curso completo de Microcontroladores PIC donde usaremos como base el PIC16F887 pero los programas pueden ser usados en cualquier PIC.

Poco a poco profundizaremos en diferentes configuraciones de controladores, tales como el control anticipado o control en cascada. Veremos como podemos colocar estos conceptos en el control predictivo mpc.

También como parte fundamental de la teoría de automatización y control de procesos, abordaremos temas de Instrumentación Industrial, donde aprenderás sobre diversos instrumentos industriales junto con su diseño matemático, veremos temas como Válvula de Control, Medidores de Caudal, Sensores de Temperatura, Sensores de Presión, entre otros.

Puedes aprovechar y ver el curso de Arduino donde veremos conceptos como por ejemplo como usar Entradas Digitales con Arduino o también como usar el puerto ADC Arduino, o ver como se usa el modulo PWM Arduino. Una de las entradas que más ha gustado es sobre la creación de un Control PID con Arduino.

Espero que la información que vaya compartiendo aquí sea de ayuda para todos aquellos estudiantes, apasionados e investigadores que quieran aprender un poco sobre este fascinante mundo del Control de Procesos.